دیپ فیک یا جعل عمیق چیست؟

تولید ویدئوهای جعلی بسیار فراگیر شده است. آیا تاکنون نقل قولهای جعلی از افراد مشهو را دیدهاید؟ اینها مصداق واقعی دیپ فیک (deepfake) هستند. دیپ فیکها از نوعی هوش مصنوعی به نام یادگیری عمیق (deep Learning) برای تولید تصویر از رویدادهای جعلی، استفاده میکنند. به همین دلیل به آنها جعل عمیق گفته میشود. آیا میخواهید، سیاستمدار یا ستاره سینما حرفهای متفاوتی بزند و کارهای عجیبی انجام دهد؟ پس از دیپ فیک یا جعل عمیق استفاده کنید.

دیپ فیک یا جعل عمیق چه کاربردی دارد؟

اغلب آنها هرزه نگاری هستند. شرکت هوش مصنوعی دیپ تریس (Deeptrace) در سپتامبر 2019 حود 15 هزار ویدئوی دیپ فیک پیدا کرد. تعداد این ویدئوها تنها در طول نه ماه قبل از این بررسی، دو برابر شده بود. 96 درصد از آنها پورنوگرافی یا هرزه نگاری بودند. از بین این ویدئوهای غیراخلاقی 99 درصدشان تصویر سلبریتیهای زن را روی چهره بازیگران پورنوگرافی ترسیم میکردند. تکنیکهای جدید حتی به افراد تازه کار هم اجازه میدهد تا با داشتن چند عکس، ویدئوهای جعلی را بسازند که خوراک فیلمهای غیراخلاقی است. به گفته دنیل سیترون، استاد حقوق دانشگاه بوستون:«فناوری دیپ فیک به سلاحی علیه زنان تبدیل شده است». علاوه بر هرزه نگاری، حقه بازیها و کلاهبرداریهای دیگری هم در این زمینه انجام میشود.

سایر کاربردهای دیپ فیک

کاربرد دیپ فیک تنها منحصر به موارد فوق نمیشود. دیپ فیک قادر به تولید عکسهای ساختگی و متقاعد کننده است. روزنامه نگاری به نام «مایسی کینزلی» در رزونامه بلومبرگ وجود واقعی ندارد. ولی دارای پروفایل در لینکدین و توئیتر است. این هویت نوعی دیپ فیک محسوب میشود. پروفایل لینکدین جعلی دیگری به نام «کیت جونز» وجود دارد که مدعی اشتغال در مرکز مطالعات راهبردی و بین المللی است .ولی برای عملیات جاسوسی خارجی تهیه شده است.

فایلهای صوتی هم برای تولید پوستههای صوتی (Voice skins) یا شبیه سازیهای صوتی (Voice Clones) به صورت جعل عمیق در میآیند. مارس سال قبل بعد از اینکه کلاهبرداری توانست صدای مدیر عامل شعبه انگلستانی شرکت نیروی آلمانی را تقلید کند، این شرکت در حدود 200 هزار یورو به بانک لهستانی پرداخت کرد. بیمه گران این شرکت، صدای تماس گیرنده را دپ فیک دانستند. ولی شواهد مشخصی از آن به دست نیامد. کلاهبرداریهای مشابهی هم برای ضبط پیام صوتی در واتساپ صورت گرفته است.

دیپ فیکها چگونه ساخته میشوند؟

پژوهشگران و استودیوهای جلوههای ویژه، مرزهای دستکاری عکس و ویدئو را جابجا کردهاند. ولی اولین دیپ فیک در سال 2017 به وسیله یکی از کاربران Reddit هنگام ادیت ویدئو ساخته شد. محتوای این کلیپها هم فیلمهای مستهجن بود. در این ویدئوها چهره سلبریتیها (گال گودت، تیلور سویفت، ساکارلت جوهانسون و دیگران) روی بدن بازیگران پورنوگرافی قرار گرفته بود.

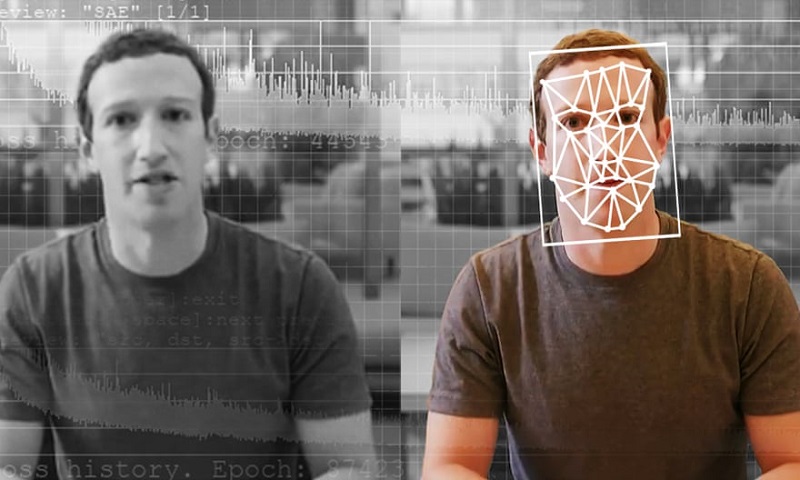

جابجایی چهره درون فیلم چند گام ساده دارد. در ابتدا باید به کمک الگوریتم هوش مصنوعی به نام encoder، هزاران عکس از چهره دو شخص مدنظر تهیه کنید. انکودر شباهتها میان دو چهره را شناسایی میکند و آنها را به ویژگیهای مشترک کاهش داده و تصاویر را در طول این فرایند فشرده میکند. سپس الگوریتم دوم هوش مصنوعی تحت عنوان decoder باید تصاویر چهره را از روی تصاویر فشرده شده، بازاریابی میکند.

چون چهرهها متفاوت هستند باید به یکی از دیکودرها آموزش دهید که چهره شخص اول را بازیابی کند و دیکودر دیگر هم باید چهره شخص دوم را بازیابی کند. برای جابجایی چهرهها هم باید تصاویر رمزگردانی شده را در اختیار دیکودر «wrong» قرار دهید. برای مثال، تصویر فشرده شخص A را در اختیار دیکودری قرار دهید که در مورد چهره شخص B آموزش دیده است. بنابراین دیکودر باید چهره شخص B را با توجه به حالات و جهت شخص A بازسازی کنید. برای رسیدن به ویدئوی متقاعد کننده، این عملیات را روی هر فریم انجام دهید.

شبکه مولد متقابل

شبکه مولد متقابل (generative adversarial network) یا Gan روش دیگری برای ساخت دیپ فیکها است. با Gan میتوان دو الگوریتم هوش مصنوعی را در تقابل با هم قرار داد. الگوریتم اول تحت عنوان ژنراتور از نویز تصادفی تغذیه کرده و آن را به تصویر تبدیل میکند. سپس تصویر به رشتهای از تصاویر واقعی (سلبریتیها) اضافه میشود که به الگورتیم دوم تحت عنوان تفکیک کننده (discriminator) منتقل شده بودند. در ابتدا تصاویر ترکیبی شباهتی به چهره ندارند. این فرایند بی نهایت بار تکرار میشود، بازخورد در مورد عملکردش ارائه شده و الگوریتمهای ژنراتور و تفکیک کننده بهبود مییابند. الگوریتم ژنراتور بعد از طی شدن چرخههای کافی و ارائه بازخوردهای لازم، میتواند چهرههای کاملاً واقع گرا از سلبریتیهایی که اصلاً وجود ندارند، تولید کند.

چه کسی دیپ فیکها را میسازد؟

هر کسی از پژوهشگران دانشگاهی و صنعتی گرفته تا افراد تازه کار، استودیوهای جلوههای بصری و تولیدکنندگان هرزه نگاری قادر به ساخت دیپ فیکها هستند. دولتها هم به عنوان بخشی از راهبردهای آنلاینشان برای شناسایی و انهدام گروههای افراطی یا برقراری تماس با افراد مدنظرشان میتوانند از فناوری کمک بگیرند.

برای این کار به چه فناوری نیاز دارید؟

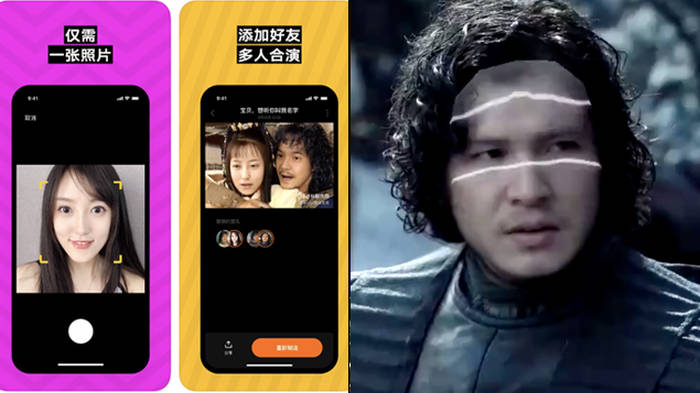

تولید دیپ فیک روی کامپیوتر استاندارد، دشوار است. اغلب این محتوای جعلی با کمک کامپیوترهای پیشرفته با کارتهای گرافیکی قدرتمند یا با قدرت محاسبات روی کلود تهیه میشوند. این شرایط زمان پردازش چند روز و چند هفتهای را به چند ساعت کاهش میدهد. برای رسیدن به فیلمهای کامل بدون پرک زدن و سایر نواقص بصری به تخصص هم نیاز دارید. اکنون ابزارهای زیادی برای کمک به تولید دیپ فیکها وجود دارند. برخی از شرکتها امکان تولید را فراهم کرده و تمام پردازش را در کلود انجام میدهند. اپلیکیشن موبایلی Zao هم به افراد اجازه میدهد تا چهره خودشان را به برخی از کاراکترهای فیلم و تلویزیون اضافه کنند. سیستم در مورد این کاراکترها، آموزش دیده است.

چگونه باید دیپ فیک را تشخیص دهیم؟

با پیشرفت فناوری، تشخیص محتوای جعلی هم دشوارتر میشود. پژوهشگران در سال 2018 متوجه شدند که چهرههای جعلی به طور طبیعی پلک نمیزنند. جای تعجب ندارد چون تصاویر موجود از افراد، آنها را با چشمان باز نشان میدهند پس الگوریتمها نمیتوانند پلک زدن را باد بگیرند. در ابتدا این علامت مثل نکتهای طلایی بود. ولی کمی بعد از انتشار نتایج این پژوهش، دیپ فیکهایی به همراه پلک زدن منتشر شدند. قانون بازی همین است. نقاط ضعف به محض بروز، اصلاح میشوند.

محتوای جعلی که کیفیت ضعیفی دارد به سرعت قابل شناسایی است. لبها یا رنگ پوست ناهماهنگ است. شاید گوشههای چهره پرک بزند. ارائه جزئیاتی مثل موها به ویژه در حاشیههای چهره بسیار دشوار است. گاهی اوقات نمایش جواهرات و دندانها در کنار نورپردازی عجیب مثل نورپردازی متناقض و انعکاس نور روی عنبیهها دچار مشکل میشود. دولتها، دانشگاهها و شرکتهای فناوری روی پژوهش در زمینه تشخیص دیپ فیکها، سرمایه گذاری میکنند. مایکروسافت، فیسبوک و آمازون چالش تشخیص دیپ فیک را برگزار کردند. در این گردهمایی، تیمهای پژوهش سراسر جهان بر سر رقابت تشخیص دیپ فیک با هم رقابت کردند.

فیسبوک هم هفته گذشته، ویدئوهای دیپ فیکی که بینندگان را در رابطه با انتخابات 2020 ایالات متحده گمراه نموده بودند، منتشر کرد. با این حال، این ویدئوها با کمک هوش مصنوعی حاوی اطلاعات گمراه کننده میشوند. این محتوای جعلی تحت عنوان «شالوفیک» (Shallowfake) یا جعل سطحی شناخته میشود که بعداً در موردشان توضیح میدهیم.

آیا دیپ فیکها ویران کننده خواهند بود؟

انتشار دیپ فیکهای بیشتر را معادل آزار، ارعاب، تحقیر، تضعیف و بیثباتی میدانیم. ولی آیا دیپ فیکها میتوانند باعث حوادث بین المللی بزرگ شوند؟ این شرایط مبهم است. دیپ فیکی از رهبری در جهان که دکمه قرمز بزرگی را فشار میدهد نباید باعث آرماگدون شود. تصاویر ماهواره ای دیپ فیک که تجمع نیروها روی مرز یک کشور را نشان میدهد هم نباید مشکل ساز شود. چون اغلب کشورها، سیستمهای تصویربرداری امنیتی مطمئنی دارند.

با این حال هنوز هم فضا برای گمراه سازی و شیطنت وجود دارد. در سال گذشته هنگامی که ایلان ماسک در نمایش زنده وب در حال مصرف سیگار دیده شد، سهام شرکت تسلا سقوط کرد. در دسامبر هم هنگامی که فیلمی از رهبران جهان در حال تمسخر ترامپ منتشر شد، ترامپ جلسه ناتو را زودتر ترک کرد. آیا دیپ فیکهای محتمل میتوانند قیمت سهام را جابجا کرده، روی رأی گیریها اثر گذاشته و تنش مذهبی ایجاد کنند؟ این شرایط محتمل هستند.

آیا این محتواهای جعلی باعث سلب اعتماد میشوند؟

جعل عمیق در کنار سایر اخبارهای رسانهای جعلی باعث سلب اعتماد از اعضای جامعه میشوند. مردم در چنین شرایطی نمیتوانند حقیقت را تشخیص دهند. هنگامیکه اعتماد از بین برود، شک کردن به رویدادهای خاص، ساده تر میشود.

در سال گذشته به دنبال انتشار ویدئوی جعلی که سربازان کشور کامرون را در حال ضرب و شتم غیرنظامیان نشان میداد و سازمان عفو بین الملل آن را منتشر کرده بود؛ وزیر ارتباطات کشور کامرون برکنار شد.

دونالد ترامپ هم که در صدای ضبط شدهای در مورد زنان لاف میزد، این محتوا را غیر واقعی خواند. در مصاحبه بی بی سی با پرنس اندرو، پرنس در مورد صحت عکس خودش با ویرجینیا گیوفر تردید داشت. ولی وکیل گیوفر این عکس را کاملاً واقعی و بدون هرگونه تغییر میدانست.

به گفته پروفسور لیلین ادواردز «جعل کردن واقعیت مشکل ساز نیست چون واقعیت محض، غیرقابل انکار است». ایشان کارشناس پیشرو در زمینه حقوق اینترنت در دانشگاه نیوکسل هستند.

شرایط حقوقی دیپ فیک چگونه است؟

دیپ فیک هنوز هم به خودی خود، غیر قانونی نیست. ولی تولید کنندگان و منتشر کنندگانش به راحتی مرتکب نقض قوانین میشوند. جعل عمیق با توجه به محتوا میتواند حق نشر یا حفاظت از دادهها را نقض کرده یا منجر به ارتکاب جرم شود. به اشتراک گذاشتن تصاویر خصوصی و جنسی هم بدون توافق فرد مقابل مثل فیلمهای مستهجن، مجازات حبس را به دنبال دارد. حقوق جعل عمیق در بریتانیا دوگانه است. قانون مجازات پورن در اسکاتلند شامل دیپ فیکها هم میشود. انتشار دیپ فیکها، تهدید به انتشار یا عکس و فیلمی که فرد دیگری را در شرایط عاطفی نشان میدهد، جرم محسوب میشود. ولی در انگلستان تصاویری که تنها از تغییر تصویر موجود ساخته شده اند از قاعده فوق مستثنی هستند.

در ایران هم تولید و انتشار دیپ فیکها از جمله جرائم رایانهای محسوب شده و با توجه به نوع محتوای منتشر شده مجازات حبس و جریمه برایش در نظر گرفته شده است.

با توسعه فناوری و دسترسی بیشتر به آن، دیپ فیکها می توانند در زمینه امور حقوقی به ویژه دعاوی حضانت فرزند و استخدام، مشکل ساز شوند. چون رویدادهای جعلی در این حوزه وارد شواهد پرونده میشوند. این محتواهای جعلی میتوانند سیستمهای بیومتریک و مبتنی بر تشخیص چهره، صدا و حرکت را فریب دهند. بنابراین احتمال کلاهبرداری در این زمینه وجود دارد. اگر کسی ناشناس با شما تماس گرفته و تقاضای پول کند، امکان ندارد که به او پول دهید. ولی اگر مادر یا خواهرتان در واتساپ با شما تماس تصویری گرفته و همین تقاضا را مطرح کند، چه میکنید؟

چه راه حلی برای جعل عمیق وجود دارد؟

هوش مصنوعی چاره کار است. هوش مصنوعی اخیراً به خوبی ویدئوهای جعلی را تشخیص داده است. ولی بسیاری از سیستمهای تشخیص موجود با یک ضعف جدی مواجه هستند. آنها در زمینه تشخیص سلبریتیها به خوبی عمل میکنند. چون ساعتها در مورد فیلمهای موجود از این افراد، آموزش دیده اند. در حال حاضر شرکتهای فناوری به دنبال سیستمهای تشخیصی با امکان تشخیص تمامی محتواهای جعلی در هر جایی هستند. راهبرد دیگر منشأ رسانهای دارد. نشانهای تجاری مناسب هستند ولی سیستم دفتری آنلاین بلاکچین هم میتواند ضبط ویدئوها، تصاویر و صداها و منشأ آنها را تأیید کند و هرگونه دستکاری در آنها را همواره مورد بررسی قرار دهد.

مطلب پیشنهادی: کاربردهای بلاکچین

آیا دیپ فیکها همواره مخرب هستند؟

اصلاً این طور نیست. بسیاری از آنها سرگرم کننده و مفید هستند. دیپ فیکهای جعل صدا به افرادی که در اثر بیماری، صدایشان را از دست داده اند کمک نموده تا صدایشان را بازسازی کنند. ویدئوهای دیپ فیک میتواند به گالریها و موزهها، جان دهند. موزه دالی در فلوریدا دارای دیپ فیکی از نقاش سورئالیست است که آثار هنری خودش را معرفی کرده و با بازدیدکنندگان سلفی میگیرد. فناوری در صنعت سرگرمی هم برای بهبود دوبله فیلم های خارجی به کار رفته و می تواند بازیگران مرده را زنده کند. برای مثال جیمز دین مرحوم، در فیلمی با محتوای جنگ ویتنام به نام Finding Jack، خوش درخشید.

شالوفیکها چه میشوند؟

عبارت شالوفیک به وسیله سم گرگوری در سازمان دیده بان حقوق بشر ابداع شد. شالوفیکها، ویدئوهایی با کمی دستکاری هستند که با ابزارهای ادیت ساده تولید میشوند. این فیلمهای ساده بسیار تأثیرگذار هستند. برای مثال شالوفیکی از نانسی پلوسی سخنگوی کاخ سفید منتشر شده که سخنرانی او را کند نموده و صدای کش دار او به دست میلیونها نفر در رسانه اجتماعی رسید. بعد از انتشار ویدئویی که جیم آکوستا خبرنگار CNN را در حال برقراری ارتباط با کارآموزی که در حال جدا کردن میکروفونش بود نشان میداد؛ این فرد به طور موقت از حضور در جلسات مطبوعاتی کاخ سفید، منع شد. بعد مشخص شد که سرعت فیلم در زمان خاصی افزایش یافته و فیلم پرخاشگرانهای را رقم زده است. بعد از این ماجرا، موقعیت مطبوعاتی کوستا به او بازگردانده شد.

در نهایت . . .

همه ما حق دستیابی به واقعیت را داریم ولی با توسعه فناوری، به سمت دنیایی مصنوعی تر پیش میرویم. این فناوری از بین نمیرود و احتمال فریبکاری وجود دارد. تنها میتوانیم با کمک همین فناوری با دیپ فیک مقابله کرده و حقیقت را تشخیص دهیم. همه روزه در شبکههای اجتماعی با انواع محتوا صوتی و تصویری مواجه هستیم. آیا تا به حال به صحت آنها شک کرده اید؟

مقاله پیشنهادی: بهترین نرم افزارهای ساخت فیلم

منبع

https://www.theguardian.com/technology/2020/jan/13/what-are-deepfakes-and-how-can-you-spot-them

.svg)